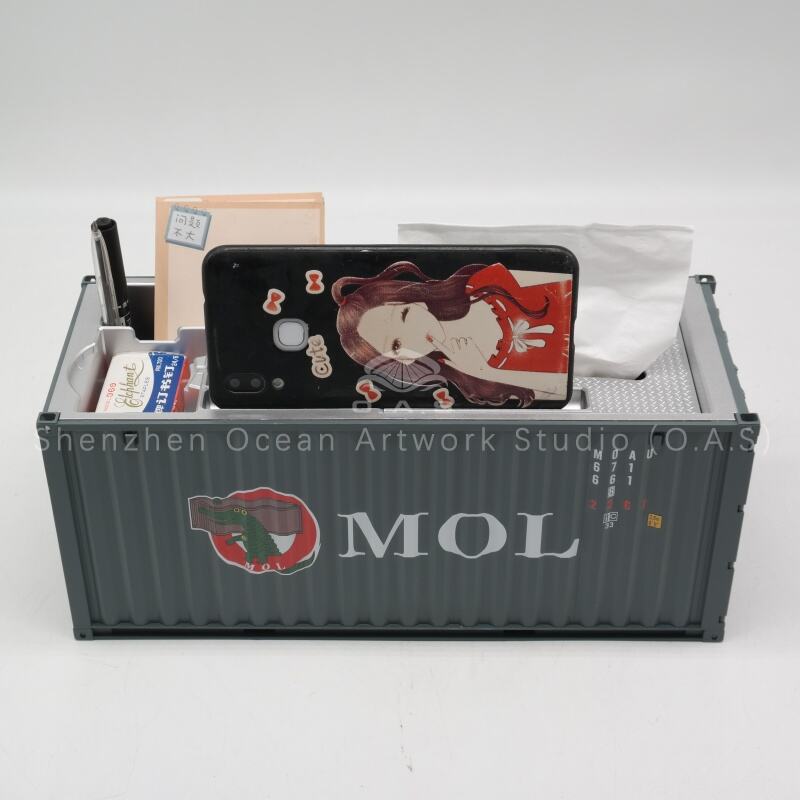

modeller av container

Modellbehållare representerar en revolutionerande metod för att distribuera, hantera och skala maskininlärningsmodeller i produktionsmiljöer. Dessa specialiserade containeriseringstekniker tillhandahåller en standardiserad ram för att paketera artificiell intelligens och maskininlärningsmodeller tillsammans med sina beroenden, körningsmiljöer och konfigurationsfiler. Genom att innesluta modeller i lättviktiga, portabla behållare kan organisationer uppnå konsekvent distribution över olika infrastrukturplattformar, från lokala servrar till molnmiljöer och edge-beräkningsenheter. Den centrala funktionaliteten hos modellbehållare handlar om versionshantering av modeller, hantering av beroenden och sömlös integration med befintliga DevOps-pipelines. Dessa behållare säkerställer strikt isolering mellan olika modellversioner samtidigt som de garanterar reproducerbara körningsmiljöer. Den tekniska arkitekturen bygger på containeriseringsprotokoll liknande Docker, men särskilt optimerade för arbetsbelastningar inom maskininlärning, med integrerade specialbibliotek, ramverk och optimeringar för körning. Modellbehållare stödjer olika maskininlärningsramverk inklusive TensorFlow, PyTorch, scikit-learn och anpassade modeller, vilket gör dem till mångsidiga lösningar för skilda AI-tillämpningar. Viktiga tillämpningar finns inom branscher såsom finansiella tjänster för bedrägeriupptäckt, hälso- och sjukvård för diagnostisk bildbehandling, detaljhandel för rekommendationssystem och tillverkning för prediktiv underhåll. Behållarna möjliggör realtidsinferens, batchbearbetning och A/B-testning, vilket gör att dataanalytiker och ingenjörer kan distribuera modeller med tillförsikt. Avancerade funktioner inkluderar automatisk skalning baserat på inferensbelastning, omfattande loggning och övervakningsfunktioner samt inbyggda säkerhetsåtgärder för att skydda känsliga modellalgoritmer och data. Modellbehållare stödjer även flermodellservning, vilket gör det möjligt för organisationer att köra flera modeller inom en enda behållarinstans, optimera resursutnyttjandet och minska driftskostnaderna. Integrationsmöjligheterna sträcker sig till populära orchestreringsplattformar som Kubernetes, vilket möjliggör sofistikerade distributionsstrategier och säkerställer hög tillgänglighet för affärskritiska AI-tillämpningar.