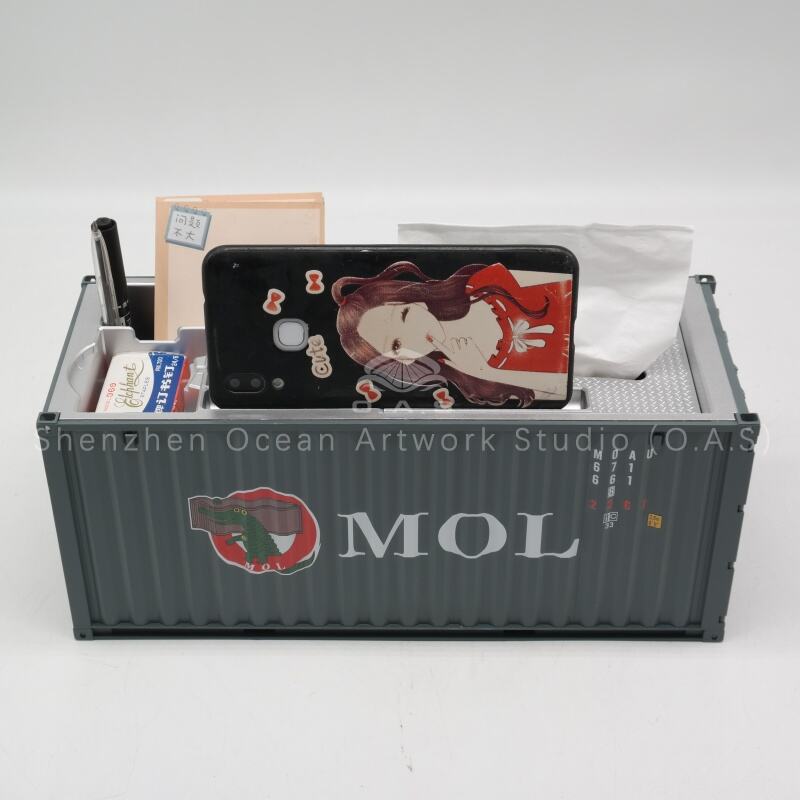

modèles de conteneurs

Les conteneurs de modèles représentent une approche révolutionnaire pour déployer, gérer et mettre à l'échelle des modèles d'apprentissage automatique dans des environnements de production. Ces solutions spécialisées de conteneurisation fournissent un cadre standardisé pour empaqueter des modèles d'intelligence artificielle et d'apprentissage automatique avec leurs dépendances, leurs environnements d'exécution et leurs fichiers de configuration. En encapsulant les modèles dans des conteneurs légers et portables, les organisations peuvent assurer un déploiement cohérent sur diverses plateformes d'infrastructure, allant des serveurs locaux aux environnements cloud et aux dispositifs de calcul en périphérie. La fonctionnalité principale des conteneurs de modèles repose sur la gestion des versions de modèles, la gestion des dépendances et l'intégration transparente avec les pipelines DevOps existants. Ces conteneurs assurent une isolation stricte entre différentes versions de modèles tout en garantissant des environnements d'exécution reproductibles. L'architecture technologique exploite des protocoles de conteneurisation similaires à Docker, mais spécifiquement optimisés pour les charges de travail d'apprentissage automatique, intégrant des bibliothèques spécialisées, des frameworks et des optimisations de runtime. Les conteneurs de modèles prennent en charge divers frameworks d'apprentissage automatique tels que TensorFlow, PyTorch, scikit-learn et des modèles personnalisés, ce qui en fait des solutions polyvalentes pour des applications d'IA variées. Les principales applications s'étendent à plusieurs secteurs, notamment les services financiers pour la détection de fraude, la santé pour l'imagerie diagnostique, le commerce de détail pour les moteurs de recommandation, et la fabrication pour la maintenance prédictive. Les conteneurs facilitent l'inférence en temps réel, le traitement par lots et les scénarios de test A/B, permettant aux scientifiques des données et aux ingénieurs de déployer des modèles en toute confiance. Les fonctionnalités avancées incluent une mise à l'échelle automatique selon la charge d'inférence, des capacités complètes de journalisation et de surveillance, ainsi que des mesures de sécurité intégrées pour protéger les algorithmes sensibles des modèles et les données. Les conteneurs de modèles prennent également en charge le service multi-modèle, permettant aux organisations d'exécuter plusieurs modèles au sein d'une seule instance de conteneur, optimisant ainsi l'utilisation des ressources et réduisant les coûts opérationnels. Les capacités d'intégration s'étendent aux plateformes d'orchestration populaires telles que Kubernetes, permettant des stratégies de déploiement sophistiquées et assurant une haute disponibilité pour les applications critiques d'IA.