Intelligente automatische Skalierung und Leistungsoptimierung

Die in Modellcontainern integrierten Funktionen zur intelligenten automatischen Skalierung und Leistungsoptimierung bieten beispielhafte Effizienz und Zuverlässigkeit für Machine-Learning-Inferenz-Workloads. Das System passt sich dabei automatisch an wechselnde Nachfragemuster an, während gleichzeitig konsistente Antwortzeiten und Kosteneffizienz gewährleistet bleiben. Dieses anspruchsvolle System überwacht kontinuierlich wichtige Leistungskennzahlen wie Anforderungsvolumen, Antwortlatenz, Ressourcenauslastung und Warteschlangentiefe, um in Echtzeit fundierte Skalierungsentscheidungen zu treffen. Die Auto-Scaling-Engine nutzt Machine-Learning-Algorithmen, um zukünftige Nachfragemuster basierend auf historischen Nutzungsdaten, Saisontrends und Geschäftszyklen vorherzusagen. Dadurch wird eine proaktive Skalierung ermöglicht, die Verkehrsspitzen antizipiert, bevor sie die Systemleistung beeinträchtigen. Zu den fortschrittlichen Leistungsoptimierungstechniken gehören intelligenter Modell-Caching, Anforderungs-Batching und dynamische Ressourcenverteilung, wodurch der Durchsatz maximiert und der Rechenaufwand minimiert wird. Das System passt die Containerinstanzen automatisch anhand konfigurierbarer Skalierungsrichtlinien an, die sowohl Leistungsanforderungen als auch Kostenbeschränkungen berücksichtigen, um ein optimales Gleichgewicht zwischen Servicequalität und Betriebskosten sicherzustellen. Anspruchsvolle Lastverteilungsalgorithmen stellen sicher, dass Inferenzanfragen an die am besten geeigneten Containerinstanzen weitergeleitet werden, basierend auf aktueller Auslastung, geografischer Lage und modellspezifischen Anforderungen. Die Leistungsoptimierungs-Engine analysiert kontinuierlich die Ausführungsmuster der Modelle, um Engpässe zu identifizieren, und implementiert automatisch Optimierungen wie Modellkompilierung, Quantisierung und hardware-spezifische Beschleunigung. Integrierte Überwachungs- und Warnsysteme bieten umfassende Transparenz hinsichtlich Skalierungsereignisse, Leistungskennzahlen und Muster des Ressourcenverbrauchs, sodass Administratoren Skalierungsrichtlinien und Optimierungsparameter präzise anpassen können. Das System unterstützt mehrere Skalierungsstrategien, darunter horizontale Skalierung für erhöhten Durchsatz, vertikale Skalierung für ressourcenintensive Modelle sowie hybride Ansätze, die beide Strategien je nach Workload-Charakteristik kombinieren. Fortschrittliche prädiktive Analysefunktionen unterstützen Unternehmen bei der Kapazitätsplanung und Budgetprognose, indem sie Nutzungs- und Wachstumsmuster analysieren. Das Auto-Scaling-System integriert sich nahtlos in Cloud-Anbieter-APIs und Kubernetes-Orchestrierungsplattformen und ermöglicht so anspruchsvolle Bereitstellungsstrategien in Multi-Cloud- und Hybrid-Infrastrukturen, während gleichzeitig konsistente Leistungsstandards gewahrt bleiben.

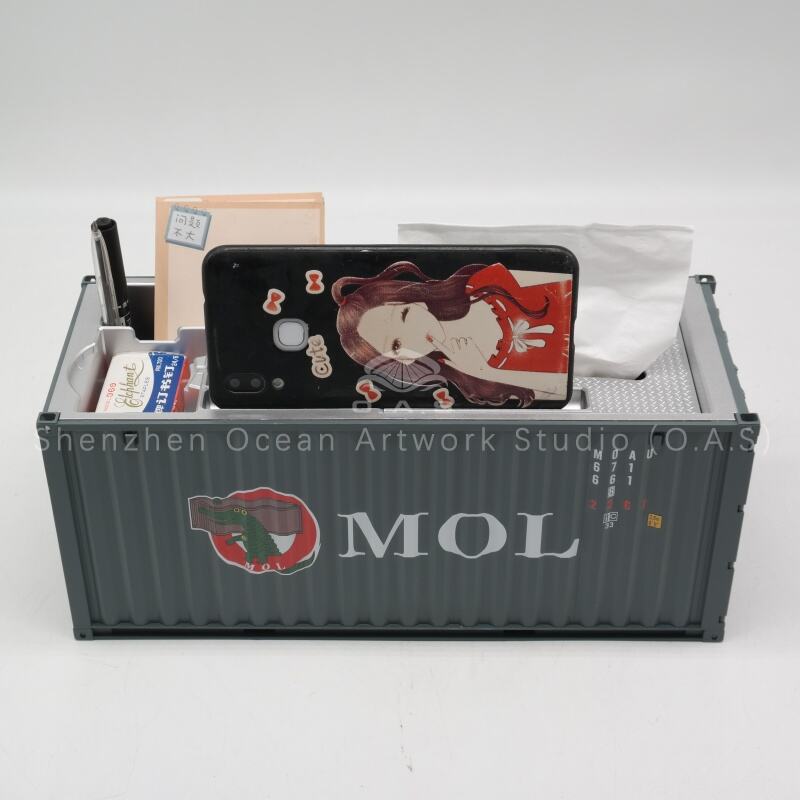

![[L]1:20 Speicherbox / Anpassbare Logofarben / Cma cgm](https://shopcdnpro.grainajz.com/category/358843/1691/9633d7e822b366f3e5ffd2a263b0ebaf/CMA%20CGM%E6%94%B6%E7%BA%B3%E7%9B%924.jpg)

![[L]1:20 Speicherbox / Anpassbare Logofarben / Evergreen](https://shopcdnpro.grainajz.com/category/358843/1691/2ad950975088dd74f612906ed1541826/%E9%95%BF%E8%8D%A3.jpg)