Nahtlose Bereitstellung und Portabilität in mehreren Umgebungen

Die benutzerdefinierte Container-Technologie für Modelle revolutioniert den Bereitstellungsprozess, indem sie eine beispiellose Portabilität über verschiedene Rechenumgebungen hinweg bietet – von lokalen Entwicklungsrechnern bis hin zu cloudbasierten Produktionssystemen. Diese außergewöhnliche Flexibilität ergibt sich aus dem Containerisierungsansatz, bei dem Machine-Learning-Modelle zusammen mit all ihren Abhängigkeiten verpackt werden und so eigenständige Einheiten entstehen, die konsistent ausgeführt werden können, unabhängig von der zugrundeliegenden Infrastruktur. Organisationen profitieren erheblich von dieser Portabilität, da damit die traditionellen Hürden zwischen Entwicklungs-, Test- und Produktionsumgebungen beseitigt werden, die häufig zu Verzögerungen bei der Bereitstellung und Kompatibilitätsproblemen führen. Der Ansatz mit benutzerdefinierten Modellcontainern gewährleistet, dass ein Modell, das auf dem lokalen Rechner eines Data Scientists trainiert wurde, identisch funktioniert, wenn es in einem Kubernetes-Cluster, auf einem Edge-Computing-Gerät oder einer serverlosen Plattform bereitgestellt wird. Diese Konsistenz reduziert den Zeitaufwand und den Aufwand für umgebungsspezifische Optimierungen und Fehlersuche erheblich, sodass Teams sich auf die Verbesserung der Modelle konzentrieren können, anstatt auf das Management der Infrastruktur. Die Portabilität erstreckt sich über einfache Bereitstellungsszenarien hinaus und unterstützt komplexe Multi-Cloud-Strategien, bei denen Organisationen ihre Machine-Learning-Arbeitslasten über verschiedene Cloud-Anbieter verteilen können, um Kosten, Leistung und Compliance-Anforderungen zu optimieren. Die Fähigkeit zur Edge-Bereitstellung wird besonders wertvoll für Anwendungen, die eine Inferenz mit geringer Latenz erfordern, wie autonome Fahrzeuge, industrielle IoT-Systeme und Echtzeit-Empfehlungs-Engines. Benutzerdefinierte Modellcontainer können für spezifische Hardware-Konfigurationen optimiert werden, einschließlich GPUs, TPUs und spezialisierter KI-Beschleuniger, und dabei denselben Code und denselben Bereitstellungsprozess beibehalten. Diese Hardware-Abstraktion ermöglicht es Organisationen, modernste Rechenressourcen zu nutzen, ohne umfangreiche Änderungen an ihren bestehenden Modellbereitstellungs-Pipelines vornehmen zu müssen. Der containerbasierte Ansatz erleichtert zudem Hybrid-Cloud-Bereitstellungen, bei denen sensible Datenverarbeitung lokal erfolgt, während öffentliche Cloud-Ressourcen zur Bewältigung zusätzlicher Rechenkapazitäten in Zeiten hoher Nachfrage genutzt werden. Das Versionsmanagement wird durch containerisierte Bereitstellungen deutlich robuster, da jede Modellversion zusammen mit ihren spezifischen Abhängigkeitsversionen verpackt ist, was Konflikte verhindert und reproduzierbare Ergebnisse über verschiedene Bereitstellungsziele hinweg sicherstellt.

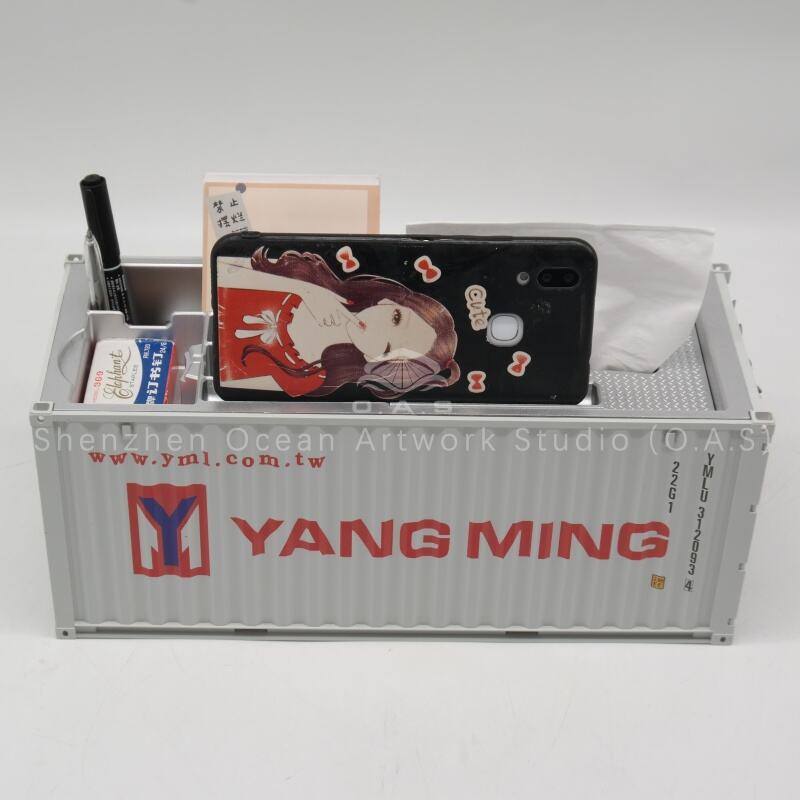

![[L]1:20 Speicherbox / Anpassbare Logofarben / Cma cgm](https://shopcdnpro.grainajz.com/category/358843/1691/9633d7e822b366f3e5ffd2a263b0ebaf/CMA%20CGM%E6%94%B6%E7%BA%B3%E7%9B%924.jpg)